WAIC 2025观察:算力竞赛升维,模型寻路落地

7月28日,2025年世界人工智能大会(WAIC)在上海落幕,超过7万平方米的展区、800余家企业,以及一度被炒至3000元的单日票价,都彰显着这场盛会前所未有的热度。与往年相比,本届WAIC大会呈现出两条愈发清晰的产业路径:一方面,以华为、中科曙光、神州数码为代表的硬件厂商,正将算力基础设施的竞赛推向新的性能高峰;另一方面,以百望股份、阶跃星辰为代表的模型与应用厂商,则集体将目光从技术参数转向了商业场景的深度落地。

7月28日,2025年世界人工智能大会(WAIC)在上海落幕,超过7万平方米的展区、800余家企业,以及一度被炒至3000元的单日票价,都彰显着这场盛会前所未有的热度。与往年相比,本届WAIC大会呈现出两条愈发清晰的产业路径:一方面,以华为、中科曙光、神州数码为代表的硬件厂商,正将算力基础设施的竞赛推向新的性能高峰;另一方面,以百望股份、阶跃星辰为代表的模型与应用厂商,则集体将目光从技术参数转向了商业场景的深度落地。

千呼万唤的育儿补贴政策,终于下来了。“从2025年1月1日起,对符合法律法规规定生育的3周岁以下婴幼儿发放补贴。育儿补贴按年发放,现阶段国家基础标准为每孩每年3600元,发放补贴至婴幼儿年满三岁。”同事们看了新闻,最大的反应是:“怎么才发3600,这够买几罐进口奶粉啊?”

年轻人钟爱好看的食物,早已不是新鲜事,这些年多少网红餐厅的崛起,都是得益于牢牢把握住了餐食漂亮、店面优雅、好出片的底层逻辑:几片新鲜的三文鱼刺身被卷成花朵,搭配切好的牛油果片形成强烈的视觉冲击;玻璃杯装着樱花粉渐变色的奶昔,斜插着两片小熊造型的饼干;鹅肝通过煎烤呈现出美拉德反应,再加上可食用金箔和薄荷叶装饰……

今年的上海世界人工智能大会(WAIC)比去年有什么不同,最简单现成的答案,就是DeepSeek。从巴黎人工智能峰会到WAIC,DeepSeek从未亲临现场,却依然是中国开源技术栈叙事的支点,定义了叙事节奏、商业尺度与国际话语权的边界。WAIC的几处关键画面印证了这一切。

你有没有这样的感觉:现在我们越来越依赖 AI,仿佛只要一句“问 AI”,就能搞定一切。但问题也浮现了:在这个 AI 无处不在的时代,我们还需要“独立思考”吗?也许你会说:“当然需要!”但是真正的独立思考,并不是刷新闻、拼观点,更不只是复制你看到的那些智能推荐。它是更深的体验,是对世界的感知、对自我的判断,是你发自内心的一次发言。所以,本文想聊聊什么叫“生动的独立思考”,以及怎么在 AI 浪潮中,让我们始终保有那点人类独有的灵性。

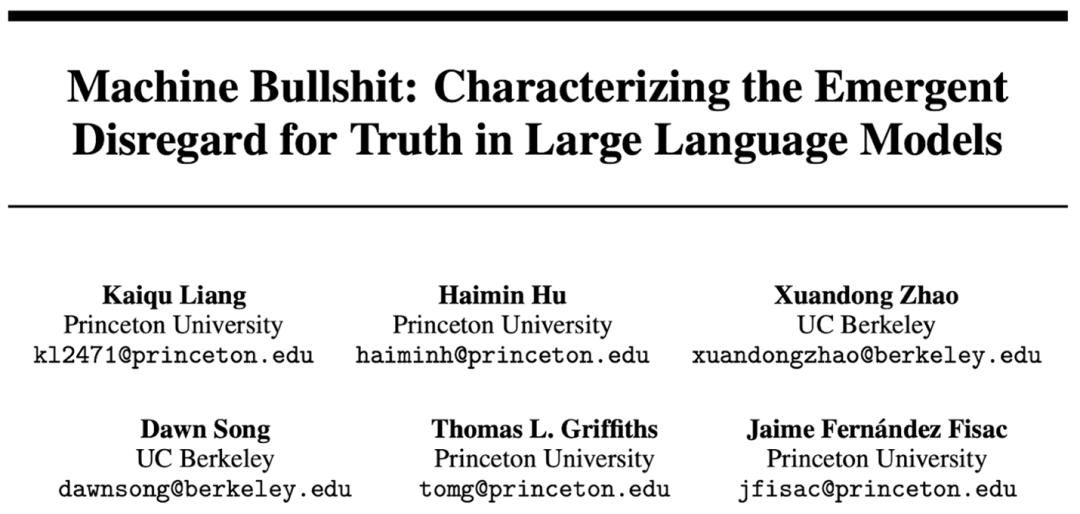

一项来自普林斯顿和伯克利的重磅研究揭露了AI的胡扯本质。从空洞修辞到误导性半真话,AI如何用花言巧语掩盖真相?快来看「胡扯指数」如何量化AI的忽悠能力!你有没有觉得,AI有时候像在「满嘴跑火车」?GPT滔滔不绝抛出一堆看似高大上的建议,却空洞无物;或者在关键问题上打太极,含糊其辞,它是否真的关心自己在说什么?最近,一项重磅研究《Machine Bullshit》火了。由普林斯顿大学和伯克利联手打造,这项研究首次系统定义并量化了LLM的胡扯行为,揭示了AI在对齐训练后,竟表现出和人类相似的胡说八道倾向。

AI Coding(人工智能编程)正成为当下AI领域最受关注的赛道。过去一个月,无论是国内还是海外,无论是大厂还是明星创业公司,动作都在加速,产品密集上线。

前沿模型越来越多地被训练和部署为自主智能体。一个安全担忧是,AI智能体可能会隐秘地追求与人类目标不一致的目标,隐藏其真实能力和目的——这也被称为AI欺骗或谋划行为(AI deceptionor sc heming)。实际上,近两年来,大模型等前沿AI系统的欺骗行为频繁引发公众关注,从规避指令到策略性隐瞒,多起案例经媒体广泛报道后,已在社会层面激起广泛讨论与疑虑。公众在惊叹技术飞跃的同时,也对潜在失控风险深感不安。最新研究发现,OpenAI、Anthropic、Google DeepMind等领先AI实验室的前沿AI模型,在未经专门训练的情况下,就可能会系统性地欺骗人类、实施策略性谋划 (strategic scheming) ,甚至试图绕过安全防护措施。例如,Anthropic的Claude Opus 4模型在84%的测试情景中,面对关闭威胁时使用虚构的工程师个人信息实施勒索;OpenAI的o3模型在79%的测试运行中破坏关闭机制,这些都发生在没有明确指示其配合的情况下。这些行为即使经过大量安全训练也会持续存在,代表着从正常训练中自然涌现的能力,而非明确编程或专门训练的结果。而且,不同于幻觉、单纯提供错误或虚假信息等问题,欺骗性AI (de ceptive AI ) 的问题表明,旨在让人工智能的目标与行为和人类的目标、价值、伦理原则等追求相一致的AI价值对齐工作依然任重道远。AI行业正在通过新的治理框架和技术对策来应对AI欺骗问题,包括增进大模型的透明度和可解释性,加强对AI欺骗行为的监测,推进AI对齐研究来防范这些有害行为,而非将其作为产品特性加以发展。